Еще одна форма насилия

По историческим меркам совсем недавно государства по всему миру начали ужесточать наказание за сексуализированные и бытовые преступления, но сегодня общество сталкивается с новой формой насилия — цифровой.

В редакцию Masa Media обратилась 21-летняя девушка, которая на условиях анонимности рассказала, что полгода назад стала жертвой цифрового насилия. Аружан (имя изменено) — активная пользовательница Instagram, часто публиковавшая свои фотографии в сети. Год назад она получила сообщение от фейкового аккаунта в директе. Ссылка вела на порносайт, где был создан якобы её профиль — десятки изображений, на которых её сделали обнажённой.

— Взяли мои реальные снимки из соцсетей. Можно сказать, что меня раздели с помощью технологий. И несмотря на то, что всё это произошло онлайн, по ощущениям это было так же страшно и ужасно, как если бы меня насильно раздели на улице и выставили перед всеми. От этого не становится менее больно. Но при этом ты не можешь ничего с этим сделать, потому что физически ничего не происходило, — рассказала она.

Дела о порнографических дипфейках должны расследовать женщины?

С 18 января в Казахстане вступает в силу закон об искусственном интеллекте, который вводит ответственность за создание и распространение дипфейков. Однако Аружан призналась, что это нововведение её не сильно обнадёживает.

По её мнению, подобные дела должны вести следователи одного пола с потерпевшими — по аналогии с практикой расследования физического сексуализированного насилия.

— Если бы эти дипфейки имели любой другой контекст, я бы сразу обратилась в полицию. Мы часто видим, как на известных бизнесменов делают дипфейки, где они якобы призывают куда-то отправить деньги и так далее.

Но порнографические дипфейки — это другое. Я, как женщина, не могу просто взять и показать такие материалы другому мужчине, пусть даже он следователь. Я не знаю, как он на это отреагирует и что потом будет делать с этими изображениями, которые у него сохранятся, — добавила она.

По мнению пострадавшей, в Уголовном кодексе должна существовать отдельная статья о порнографических дипфейках под названием «цифровое насилие». Либо цифровое насилие должно быть приравнено к физическому.

Платформы должны нести ответственность

Известная учёная, феминистка и правозащитница Айгерим Кусайынкызы также считает, что новый закон об искусственном интеллекте недостаточно защищает жертв цифрового насилия. По её словам, действующее регулирование в большей степени сосредоточено на экономических и технологических аспектах.

По мнению Кусайынкызы, ответственность должны нести и компании — разработчики ИИ-платформ.

— Для эффективной защиты необходимы гражданские механизмы защиты жертв: право на компенсацию, ускоренное удаление контента, внесудебные процедуры; а также обязанности платформ — аудит алгоритмов, фильтры генерации, ведение журнала запросов, эффективный механизм жалоб и обязанность сотрудничества с правоохранительными органами.

Без этих элементов мы будем регулировать рынок, но не защищать людей. ИИ может стать инструментом расширения возможностей, но может превратиться и в инфраструктуру цифрового насилия. От того, какую архитектуру мы выберем сегодня, зависит цифровое будущее завтра, — подчеркнула она.

Цифровой патриархат

Кусайынкызы также указала на более глубокую системную проблему. По её словам, технологии не являются нейтральными, поскольку отражают существующие социальные и культурные паттерны, включая гендерное неравенство.

— Скандал с чат-ботом, который по запросу пользователей «раздевал» женщин и детей, стал показательным примером цифрового насилия, при котором алгоритм усиливает ту же систему власти, что существует офлайн. Одной из ключевых проблем ИИ остаётся встроенная предвзятость. Она проявляется, в том числе, в недостаточной репрезентации женщин и маргинализированных групп в данных, на которых обучаются алгоритмы, — отметила она.

Правозащитница обратила внимание и на гендерную однородность технологического сектора, где большинство разработчиков ИИ — мужчины.

— Этот дисбаланс влияет на архитектуру алгоритмов и дизайн систем, которые часто игнорируют разнообразие гендерных идентичностей и опыта. Исследователи называют это явление «цифровым патриархатом». Чат-бот — один из последних кейсов, где платформа воспроизводит логику мужского взгляда, встроенную в алгоритм, — сказала она.

Можно ли обезопасить себя от цифрового насилия?

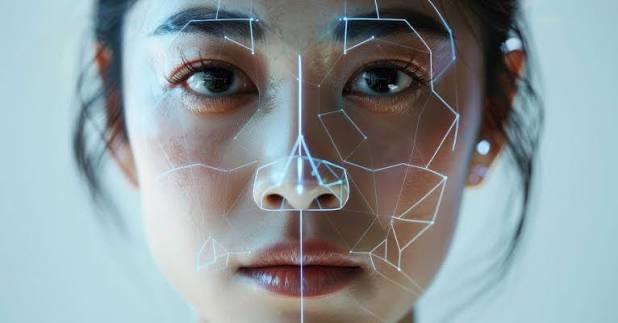

Журналист Masa Media поговорил с экспертом по искусственному интеллекту Мейржаном Ауелханом. Он признал, что на сегодняшний день не существует технологии, способной полностью защитить человека от дипфейков.

По его словам, если в открытом доступе есть качественные фотографии и видео, этого уже достаточно для создания поддельного контента.

— Речь идёт не о полной защите, а о снижении рисков. Лучше всего защищены те, кто редко публикует изображения с чётко различимым лицом и голосом, — отмечает эксперт.

При этом Ауелхан подчёркивает, что цифровое насилие редко остаётся исключительно в онлайне. Порнографические дипфейки часто приводят к психологическим травмам, социальной изоляции, угрозам и преследованию в реальной жизни.

О проблеме цифрового насилия с использованием ИИ уже говорят на уровне ООН. По данным организации, 38% женщин подвергались онлайн-насилию, а 85% становились его свидетелями. До 95% всех дипфейков носят порнографический характер, 99% жертв — женщины.

Напомним, в начале января один из популярных чат-ботов оказался в центре международного скандала из-за генерации сексуализированных дипфейк-изображений реальных людей. Анализ показал создание тысяч таких изображений в час. В числе первых доступ к сервису заблокировали Индонезия и Малайзия, сославшись на нарушение законов о непристойном контенте. Расследования и требования предоставить объяснения инициировали Индия, Франция и Великобритания.

00:00

00:00

3287

3287

Facebook

Facebook

Vkontakte

Vkontakte

Telegram

Telegram

Whatsapp

Whatsapp

Нет комментариев.